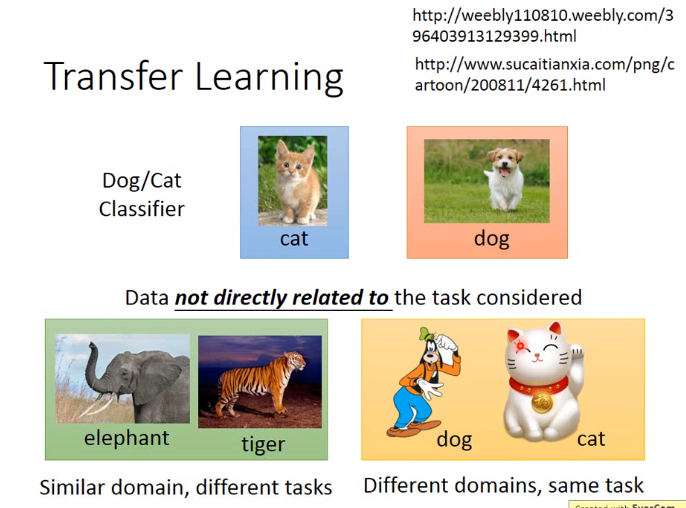

转移学习

如下图,target data与task有直接关联的,source data与task没有直接相关联的

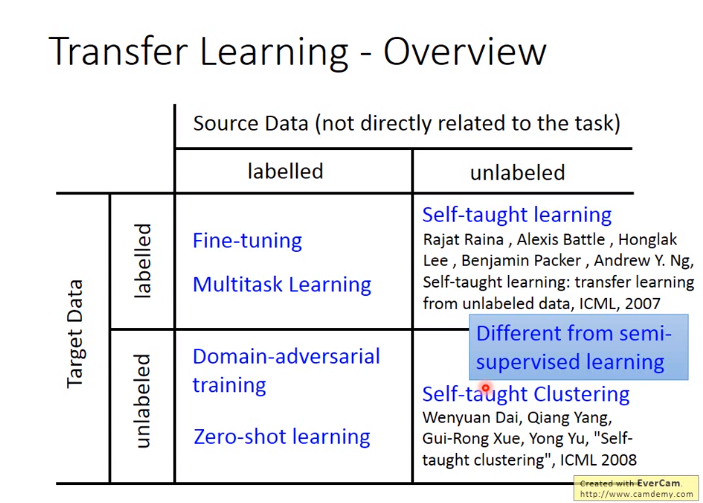

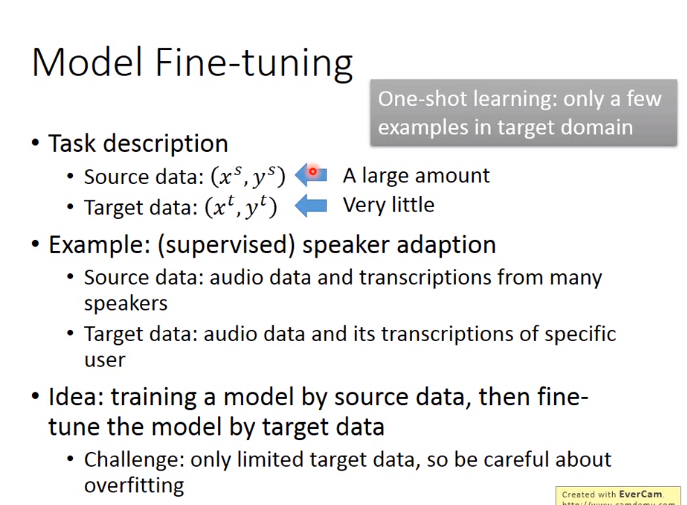

1. Model Fine-tuning (taget data和source data均有label)

一般用于source data很多,target data很少(一般只有几个)的情形,常用于语音识别,用source data做训练

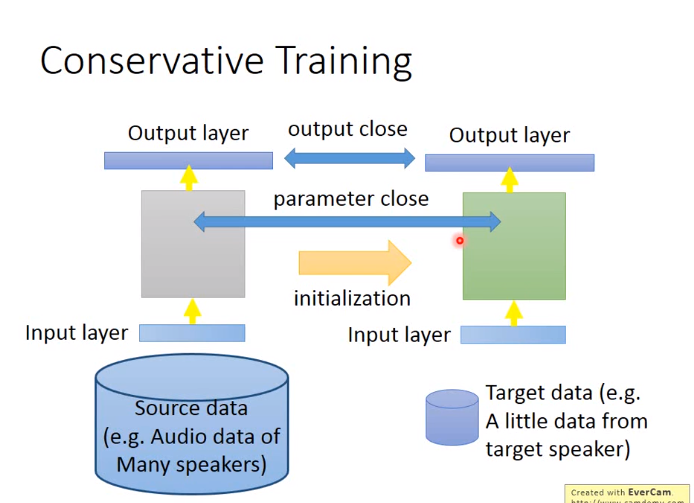

由于target data少,一般有特殊的处理方式,如Conservative training

conservative training

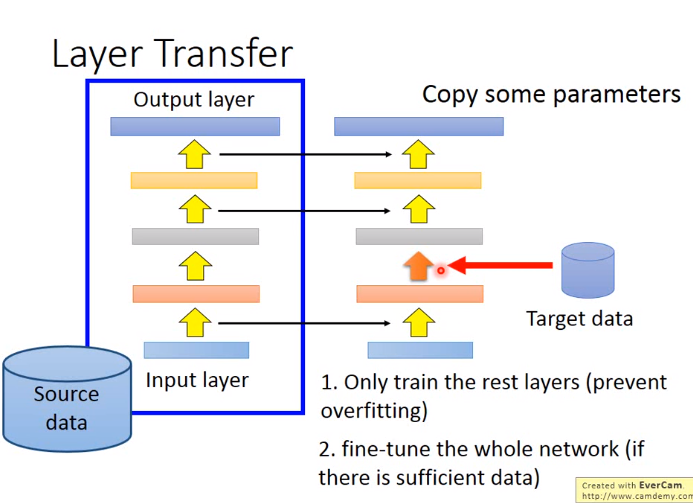

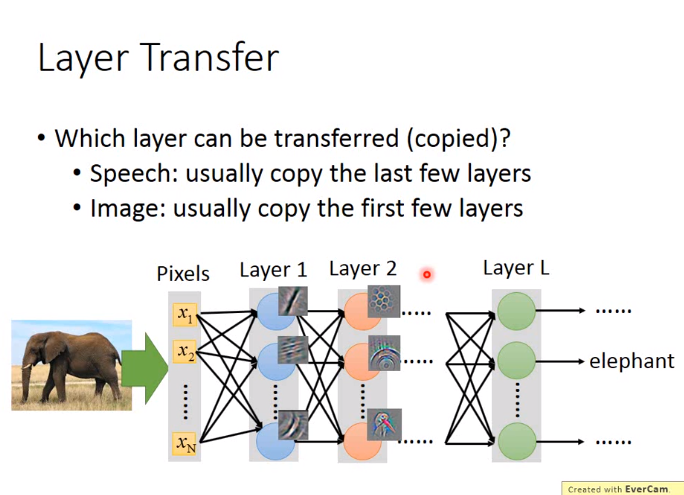

target date可以只调整某一层的参数,但是若target数据足够多,可以调整全部的参数

一般copy参数针对不同的场景有不同的方法,如下图

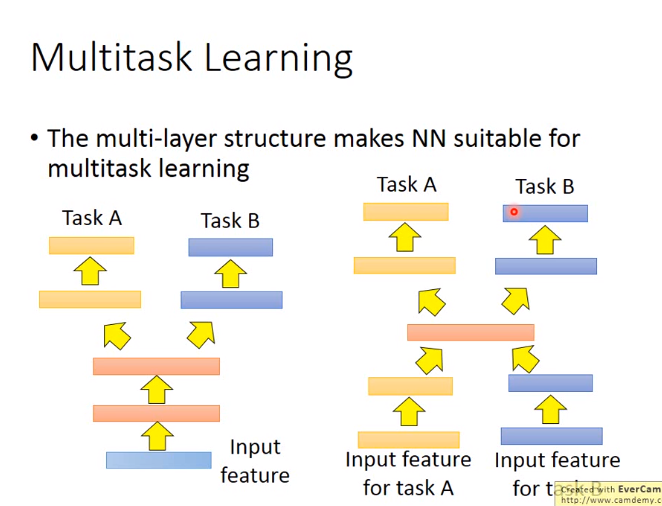

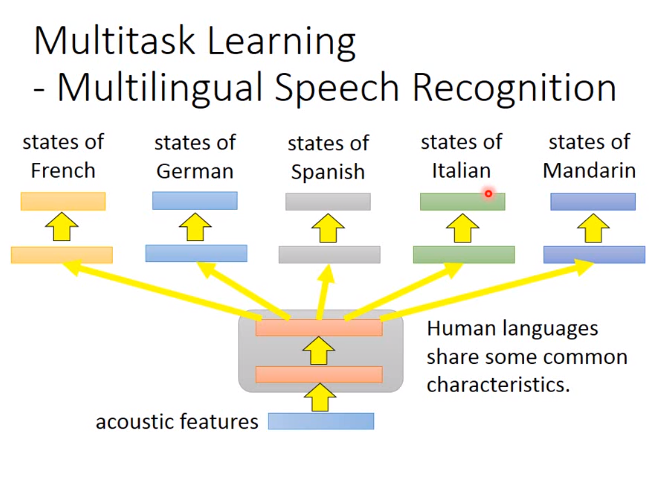

2. Multitask Learning (target data和source data均有label)

需要输出多个task

比如多国语言识别

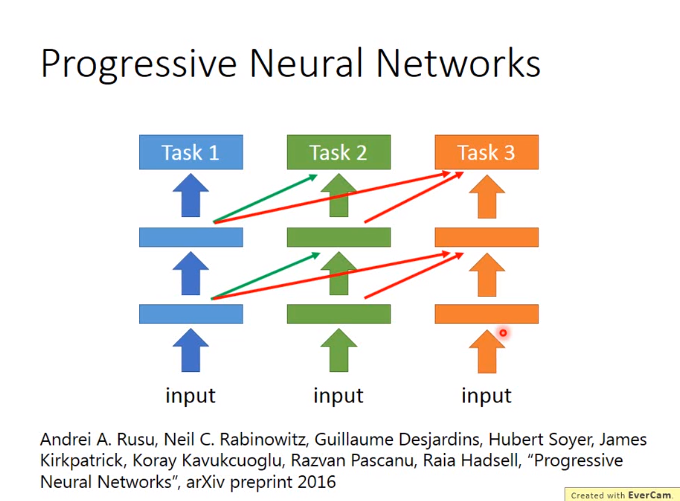

Progressive neural networks

每个task分别用不同的模型训练,但是前一个task的hidden layer输出可以是后一个task的hidden layer的输入,只是做BP算法时,前一个task的参数不变,如下图

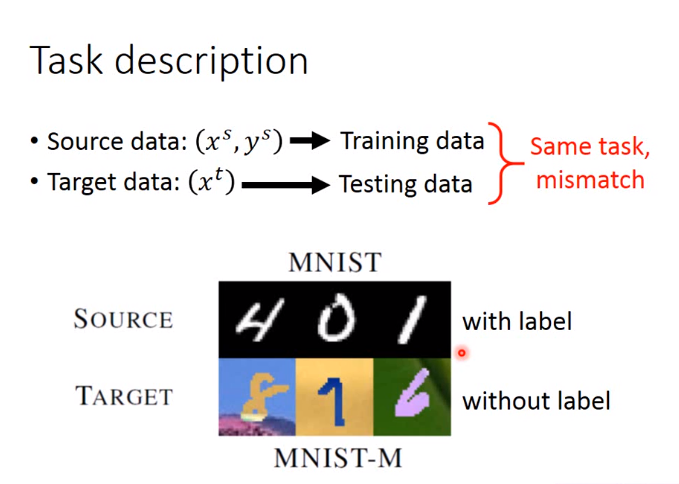

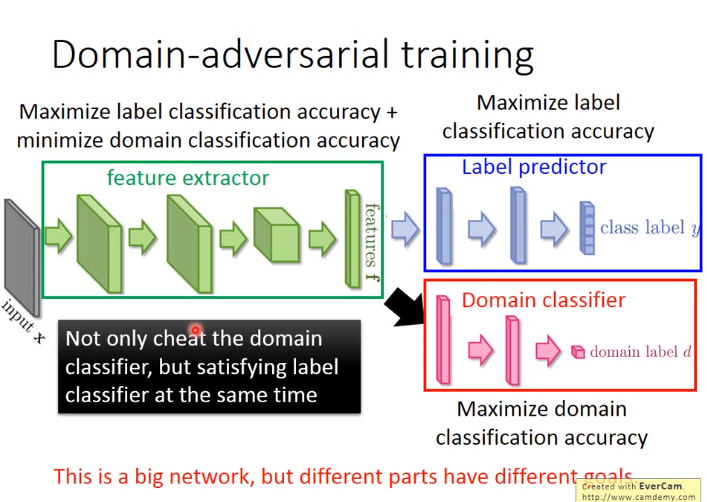

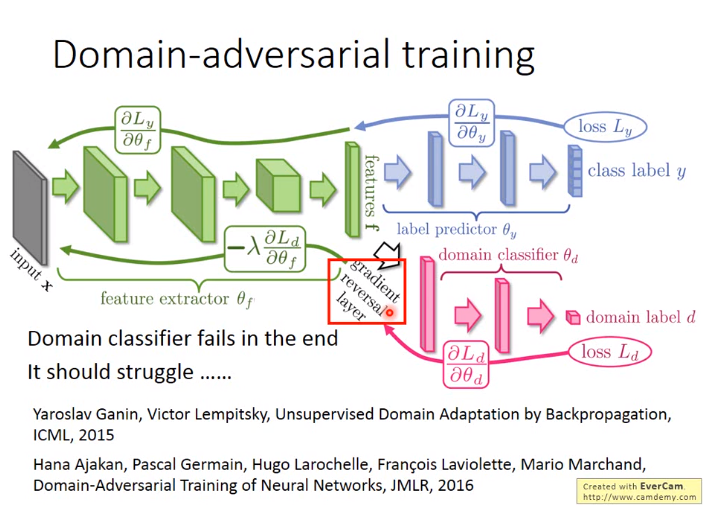

3. Domain-adversarial training (target data无label,source data有label)

Domain-adversarial training中target data和source data的目标是一致的。

如下图,如果训练集与测试集分布不同,那么效果并不好

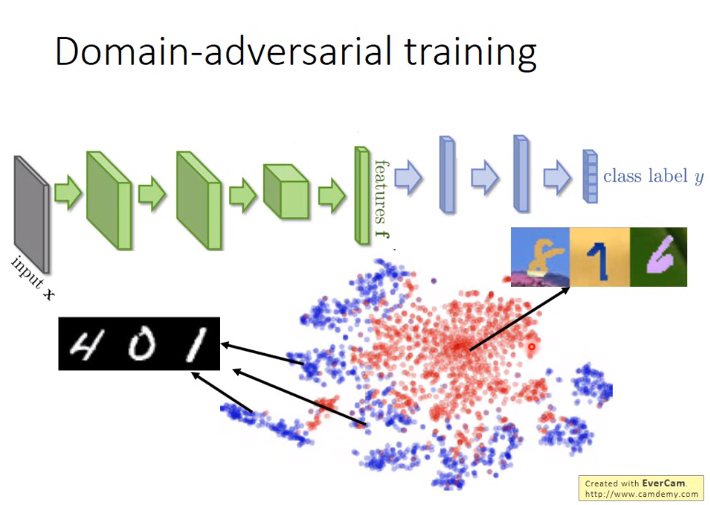

使用Domain-adversarial training使source data和target data转到同样的domain,即有接近的分布

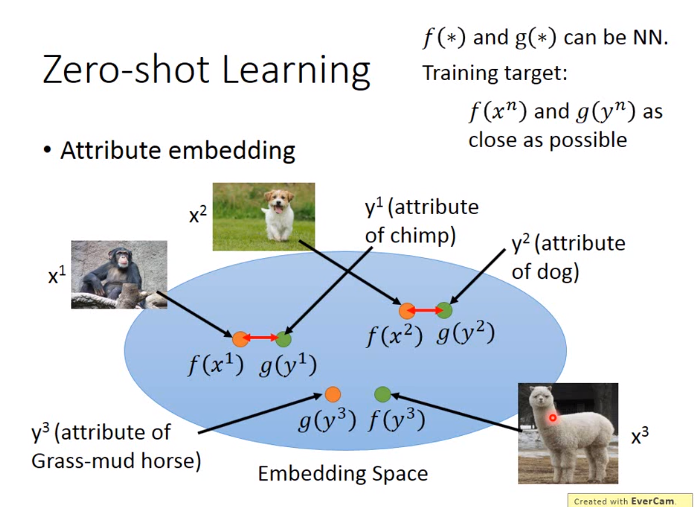

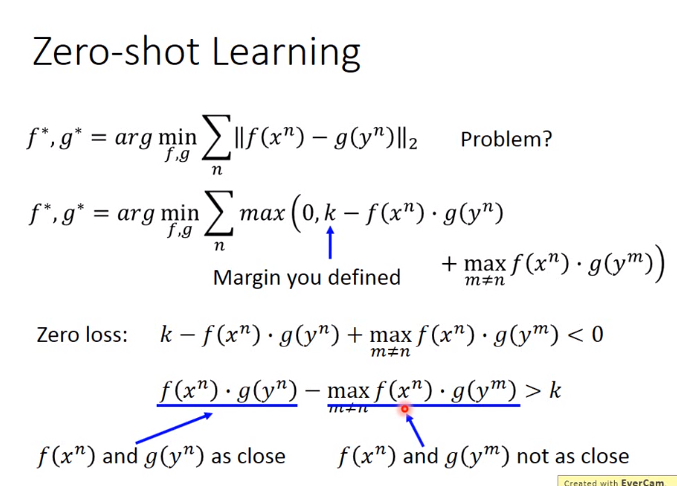

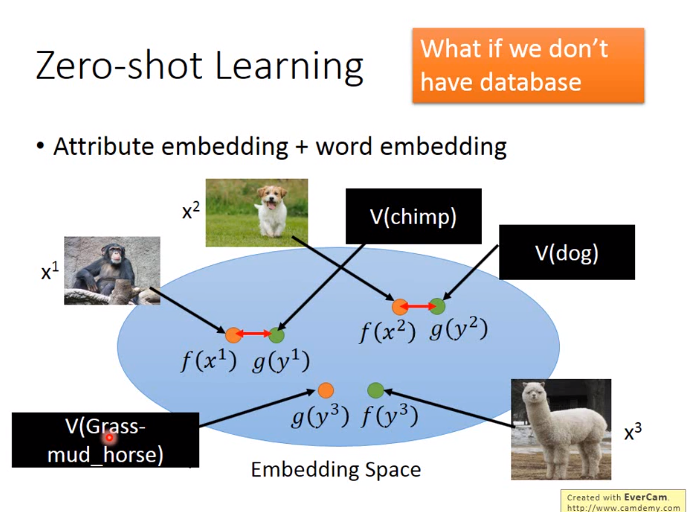

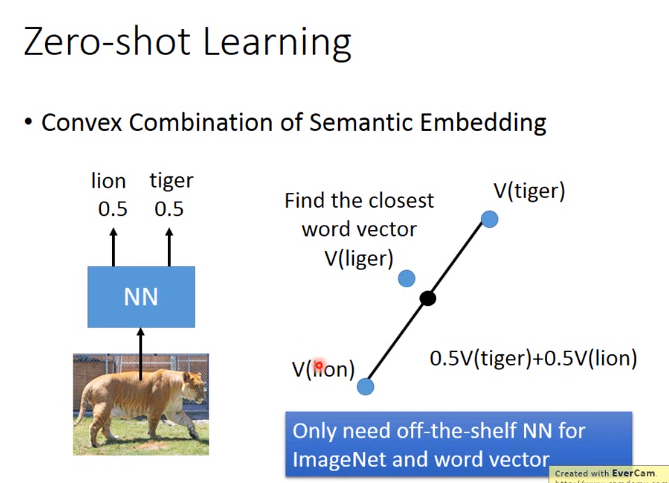

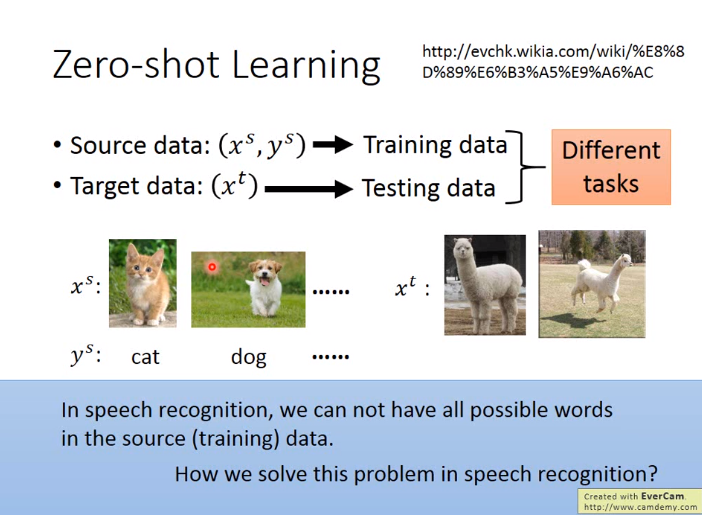

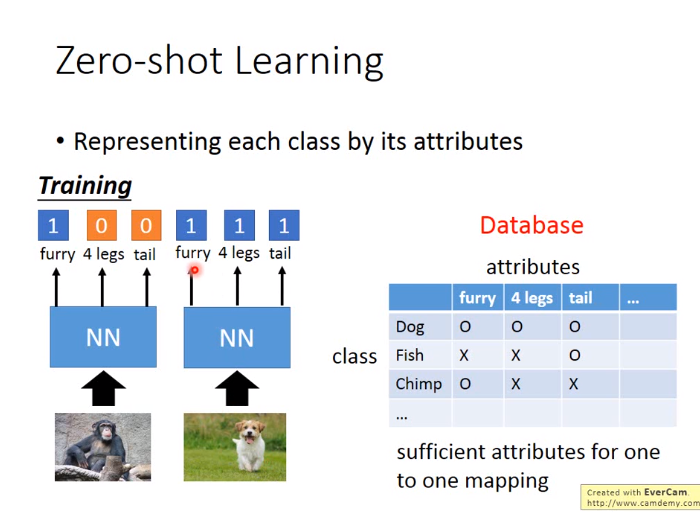

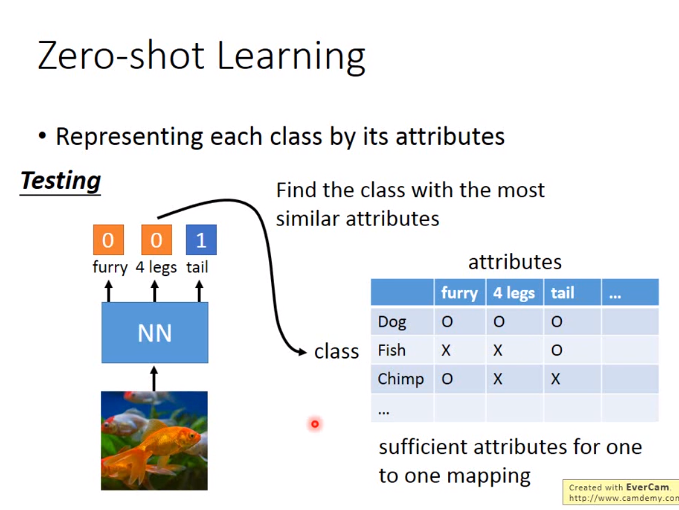

4. Zero-shot learning (target data无label,source data有label)

Zero-shot learning中target data和source data的目标是不一致的。

下图有错,首先需把\(g(y^3)和f(y^3)\)的颜色进行调换,然后把\(f(y^3)转换为f(x^3)\)